الروبوتات وإمكانية تعلم الأخلاق واكتساب الفضائل.. ماذا يقول فيلسوف فرنسي؟

يتساءل الفيلسوف مارتن جيبر -الباحث في جامعة مونتريال- "كيف يمكن برمجة آلة أو خوارزمية على عامل أخلاقي مصطنع يجعلها تحسن التصرف؟ إن التفكير في هذا الأمر سيجبرنا على الخوض في التفاصيل والتساؤل عما إذا كنا حقا بحاجة إلى هذه الروبوتات".

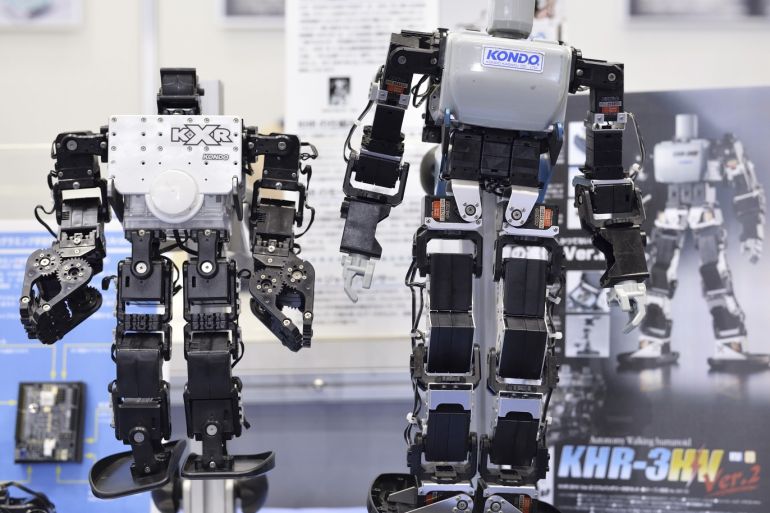

لا يزال موضوع المعضلة الأخلاقية للذكاء الاصطناعي يثير الكثير من الجدل في حقول الفلسفة والتكنولوجيا على حد سواء، فسلوك تلك الآلات الذكية الاصطناعية المحتمل يبقى محل شك وريبة من كثيرين.

ويرى الفيلسوف مارتن جيبر -الباحث في "جامعة مونتريال" (Université de Montréal) وعضو في مركز أبحاث الأخلاقيات ومعهد تثمين البيانات- أنه من الضروري تدريب خوارزميات التعلم الخاصة بالروبوتات وروبوتات الدردشة والآلات الأخرى على آراء وسلوكيات البشر ذوي الأخلاق الحسنة.

وفي حوار نشرته صحيفة "لوموند" (Le Monde) الفرنسية، قال الكاتب ديفيد لاروسيري إن مارتن جيبر طبّق في عام 2015 نظريات أخلاقية كلاسيكية على النباتية الصرفة (نظام غذائي) في كتاب "النظر إلى شرائح اللحم كما لو كانت حيوانا ميتا". وقد فعل الشيء نفسه في مجال الروبوتات والآلات والخوارزميات الأخرى في كتاب بعنوان "تأنيب الروبوتات".

تعليم الأخلاق

في سؤال الصحيفة عن السبب الذي يجعل الفيلسوف يتعامل مع أجهزة الذكاء الاصطناعي -مثل السيارات ذاتية القيادة أو روبوتات الدردشة أو أنظمة التوصيل عبر الإنترنت- أجاب الفيلسوف أن هذه اللحظة تعتبر مثيرة حقا للفيلسوف لأنه يمكن أن نطرح على أنفسنا أسئلة حول هذه الأجهزة التي تعد بدورها مبتكرة وأساسية للغاية. وهي عملية للغاية لأنها تحتوي على تطبيقات فورية وعاجلة، مستحضرا سؤال الأخلاق في "معضلة الترولي" التي طرحتها الفيلسوفة البريطانية فيليبا فوت في 1967.

وتتخيل تلك المعضلة الافتراضية وجود شخص على مفترق قضبان قطار، حيث يستطيع تغيير مسار القطار بمقبض في يده، وأمامه شخص مربوط بإحكام على القضبان وعلى المسار الثاني هناك 5 أشخاص مربوطين أيضا.

ووصولا إلى التطورات الحديثة في الذكاء الاصطناعي، قال جيبر إن الفلاسفة فكروا في الإجابات والآن أصبح رأيهم مهما، ولا بد من توجيه المبرمجين الذين ستختار الخوارزميات الخاصة. "إن الذكاء الاصطناعي يجبرنا على اتخاذ قرارات بشأن الصواب والخطأ، ولم يعد مجرد تجربة فكرية".

وتساءل الفيلسوف "كيف يمكن برمجة آلة أو خوارزمية على كود أخلاقي مصطنع يجعلها تحسن التصرف؟ إن التفكير في هذا الأمر سيجبرنا على الخوض في التفاصيل والتساؤل عما إذا كنا حقا بحاجة إلى هذه الروبوتات. إن هذه المسألة مثيرة للاهتمام وضرورية لأن الخوارزميات تؤثر على حياة الناس".

ويضيف "قد يكون ذلك واضحا في حالة السيارة ذاتية القيادة ومعضلة الترولي التي يكون فيها اتخاذ القرارات الحاسمة نادرا، ولكن يختلف الأمر بالنسبة لخوارزميات يوتيوب أو فيسبوك التي تؤثر بشكل كبير على تدفق المعلومات. كلما طورنا المزيد من القوى الجديدة، زادت مسؤوليتنا الأخلاقية. حتى خلف روبوت الدردشة، هناك معضلات أخلاقية خطيرة".

فلسفة تحليلية

أوضح الفيلسوف أن الفلسفة التحليلية تقوم على 3 مقاربات رئيسية، و3 نظريات أخلاقية يمكن تطبيقها في هذا المجال. بعيدا عن معضلة الترولي، تضع نظرية "الواجب الأخلاقي" للفيلسوف الألماني إيمانويل كانط (1724 – 1804) قواعد عامة؛ وهي تمثل أساس نهج لجنة أخلاقيات السيارات الألمانية ذاتية القيادة، التي تنص على أنه لا ينبغي للآلة أن تميز بين الناس، لذلك لا يوجد خيار بين إنقاذ حياة رجل عجوز أو طفل أو إنقاذ حياة 5 أشخاص بدلا من شخص واحد.

يُسمى النهج الثاني النفعية أو العواقبية التي تشير إلى أن فعل الصواب لا يعني اتباع القواعد بحذافيرها وإنما التفكير في الخيار الذي يضمن أفضل النتائج الممكنة؛ أي التفكير في العواقب، وبناء على ذلك، ينبغي تفضيل إنقاذ 5 أرواح بدلا من حياة واحدة أو إنقاذ حياة شاب أكثر من حياة مسن، على حد تعبير الفيلسوف الفرنسي.

وأشار الفيلسوف إلى أن الذكاء الاصطناعي دمج بالفعل هذين النهجين، حيث إن ما يسمى الأنظمة "الخبيرة" الخاصة بالقواعد تعتبر أكثر أخلاقية، في حين أن النفعية سمة التعلم الآلي الذي يسعى إلى تحسين الوظائف.

فيما يتعلق بالأسباب التي تجعل كل من هذه المقاربات غير مرضية، بيّن جيبر أن صعوبة النهج الأخلاقي تكمن في أنه يجب أن يكون لديك كل القواعد، ويضيف "ليس لدينا كتيبات تحتوي على كل هذه القواعد. كما أن القواعد يمكن أن تكون غير متوافقة مع بعضها البعض".

وفي حديثه عن النهج الثالث للخروج من هذه المعضلة، تطرق الفيلسوف إلى نظرية طورتها الفلسفة الأخلاقية ألا وهي أخلاقيات الفضيلة؛ فبالنسبة للروبوت "الفاضل"، فإن اتخاذ القرار "غير مباشر"، لأن العمل الصالح هو ما يمكن أن يفعله الشخص الفاضل في ظل ظروف مماثلة، بعبارة أخرى، يهتم علماء الأخلاق بالأفعال، والنفعيون بالنتائج، وعلماء أخلاق الفضيلة بالعوامل.